نرم افزارهای تحلیل متن MaxQDA و NVivo: مقایسه، راهنمای استفاده و اهمیت تحلیل متن در پژوهشهای علوم انسانی

تحلیل متن ابزاری است که در پژوهشهای علوم انسانی مورد استفاده قرار میگیرد و به ما امکان میدهد تا به سؤالات پژوهشی خود پاسخ دهیم. در این مقاله، نرم افزارهای تحلیل متن MaxQDA و NVivo مقایسه شده اند و قابلیت های مشابهی دارند. هر دو نرم افزار قابلیت های گسترده ای برای تحلیل متن را ارائه میدهند. با استفاده از این نرم افزارها، میتوان متنها را برچسبگذاری کرده و تحلیلهای پیچیده را انجام داد. نرم افزار NVivo امکانات مانند تحلیل محتوا، تحلیل مفهومی و تحلیل شبکههای اجتماعی را نیز داراست.

تحلیل متن یکی از روشهای مهم در پژوهشهای علوم انسانی است که به ما امکان میدهد متنها را بررسی و تحلیل کنیم و به دنبال الگوها، مفاهیم و روابط درون متن باشیم. با توجه به حجم بزرگ دادههای متنی در دنیای امروز، استفاده از نرم افزارهای تحلیل متن ضروری است تا این کار را به صورت سریع و دقیق انجام دهیم.

در این مقاله، دو نرم افزار تحلیل متن بسیار معروف و قدرتمند، یعنی MaxQDA و NVivo معرفی و مقایسه میشوند. MaxQDA و NVivo هر دو ابزارهای قدرتمندی هستند که تحلیل متن را برای محققان و پژوهشگران آسان میکنند و امکانات و ویژگیهای متنوعی را در اختیار کاربران قرار میدهند.

در بخش اول این مقاله، به معرفی تحلیل متن و اهمیت آن در پژوهشهای علوم انسانی خواهیم پرداخت. در بخش دوم، نرم افزارهای MaxQDA و NVivo به طور جامع مورد بررسی قرار میگیرند و ویژگیها، قابلیتها و محدودیتهای هر یک بررسی میشوند. در بخش سوم، راهنمایی برای استفاده از این دو نرم افزار پرطرفدار ارائه میشود تا به محققان و پژوهشگران کمک کند تا با استفاده از این ابزارها بهترین نتایج را در تحلیل متنها به دست آورند.

با مطالعه این مقاله، خوانندگان میتوانند با نرم افزارهای MaxQDA و NVivo آشنا شده و در انتخاب و استفاده از این ابزارها بهترین تصمیمها را بگیرند. این مقاله برای پژوهشگران، دانشجویان و علاقهمندان به حوزه تحلیل متن و استفاده از نرم افزارهای مرتبط، ارزش آموزشی و کاربردی دارد.

- 1. معرفی تحلیل متن و اهمیت آن در پژوهشهای علوم انسانی

- 2. مقایسه و بررسی نرم افزارهای تحلیل متن MaxQDA و NVivo

- 3. راهنمای استفاده از نرم افزارهای تحلیل متن MaxQDA و NVivo

1. معرفی تحلیل متن و اهمیت آن در پژوهشهای علوم انسانی

تحلیل متن یکی از مهمترین ابزارها در پژوهشهای علوم انسانی است. این روش، امکان بررسی و تحلیل دقیق و جامع متون را فراهم میکند و به ما اجازه میدهد تا به طور دقیق و جامع به سؤالات پژوهشی خود پاسخ دهیم.

اهمیت تحلیل متن در پژوهشهای علوم انسانی به دلیل مجموعهای از عوامل است. اولاً، تحلیل متن میتواند به ما کمک کند تا الگوها و مفاهیم کلیدی درون متون را شناسایی کنیم. با تجزیه و تحلیل متن، میتوانیم بدانیم که کدام قسمتها از متن به ماهیت موضوع اصلی مربوط میشوند و کدام قسمتها جزئیات فرعی هستند.

دوماً، تحلیل متن امکان میدهد تا اطلاعات مختلفی را از متن استخراج کنیم. با استفاده از نرم افزارهای تحلیل متنی مانند Nvivo و maxqda، میتوانیم به طور همزمان و همزمان دادهها را بررسی کنیم و اطلاعات مفید را استخراج کنیم. این اطلاعات میتواند شامل الگوها، مفاهیم، ارتباطات و تغییرات زمانی باشد.

سوماً، تحلیل متن به ما کمک میکند تا دادهها را به طور کمی و کیفی تجزیه و تحلیل کنیم. با استفاده از روشهای تحلیل متن، میتوانیم دادهها را به صورت کمی مانند تعداد ظاهر شدن یک الگو یا مفهوم خاص در متن محاسبه کنیم. همچنین، میتوانیم دادهها را به صورت کیفی مانند نحوه تفسیر مفاهیم و روابط بین آنها تحلیل کنیم.

به طور کلی، تحلیل متن با استفاده از نرم افزارهای مانند Nvivo و maxqda، به ما امکان میدهد تا به طور دقیق و جامع به سؤالات پژوهشی خود پاسخ دهیم و دادههایمان را به صورت کمی و کیفی تحلیل کنیم. این ابزارها به ما امکان میدهند تا به طور موثر و کارآمد به تجزیه و تحلیل و تفسیر دادههایمان بپردازیم و نتایج قابل اعتمادی را به دست آوریم.

2. مقایسه و بررسی نرم افزارهای تحلیل متن MaxQDA و NVivo

در این بخش، نرم افزارهای تحلیل متن MaxQDA و NVivo را مقایسه و بررسی خواهیم کرد. تحلیل متن به عنوان روشی برای بررسی داده های کیفی در تحقیقات اجتماعی و روانشناسی استفاده می شود. این روش امکان تحلیل و تفسیر داده های متنی را فراهم می کند و به محققان کمک می کند تا الگوها، موضوعات و روابط موجود در داده ها را شناسایی و تحلیل کنند.

MaxQDA و NVivo دو نرم افزار محبوب و قدرتمند برای تحلیل متن هستند. هر دو نرم افزار امکانات و قابلیت های مشابهی دارند، اما در بعضی جنبه ها تفاوت هایی نیز وجود دارد.

MaxQDA به عنوان یکی از پیشروان در زمینه تحلیل متن شناخته می شود. این نرم افزار امکانات گسترده ای برای تحلیل متن ارائه می دهد، از جمله قابلیت نشانه گذاری متن، تحلیل مضمون، تحلیل روایتی و تحلیل شبکه ای. همچنین، MaxQDA قابلیت های استنتاجی مانند تحلیل کددهی، تحلیل مقایسه ای و تحلیل ترکیبی را نیز ارائه می دهد. این نرم افزار برای تحلیل داده های بزرگ و پیچیده بسیار مناسب است و به کاربران امکان مشارکت در تحلیل های گروهی را نیز می دهد.

NVivo نیز یک نرم افزار قدرتمند و محبوب برای تحلیل متن است. این نرم افزار امکانات متنوعی را برای تحلیل متن ارائه می دهد، از جمله قابلیت تحلیل مضمون، تحلیل روایتی و تحلیل مفهومی. همچنین، NVivo قابلیت های تحلیلی مانند تحلیل کددهی، تحلیل مقایسه ای و تحلیل مدلی را نیز دارد. این نرم افزار امکاناتی برای تصویری سازی داده ها و ایجاد گزارش های تحلیلی نیز فراهم می کند.

در مقایسه این دو نرم افزار، مشخص است که هریک از آنها قابلیت ها و قابلیت های منحصر به فردی دارند. MaxQDA برای تحلیل داده های بزرگ و پیچیده بسیار مناسب است، در حالی که NVivo امکانات بیشتری برای تصویرسازی داده ها و ایجاد گزارش های تحلیلی دارد. بنابراین، انتخ

3. راهنمای استفاده از نرم افزارهای تحلیل متن MaxQDA و NVivo

راهنمای استفاده از نرم افزارهای تحلیل متن MaxQDA و NVivo

در دنیای امروز، تحلیل متن به عنوان یکی از روشهای مهم در پژوهشهای کیفی و کمی استفاده میشود. با رشد و توسعه فناوری، نرم افزارهای تحلیل متن نیز برای کمک به پژوهشگران در انجام تحلیلهای کیفی و کمی بر روی متون، به کار گرفته میشوند. در این بخش، نرم افزارهای MaxQDA و NVivo را بررسی خواهیم کرد و راهنمای استفاده از آنها را ارائه خواهیم داد.

MaxQDA یکی از محبوبترین نرم افزارهای تحلیل متن است که قابلیتهای گستردهای برای تحلیل و مدیریت دادههای متنی فراهم میکند. با استفاده از MaxQDA، میتوانید متنهای خود را برچسبگذاری کنید، کدهای مربوط به موضوعات و مفاهیم مختلف ایجاد کنید و تحلیلهای متنی پیچیده را انجام دهید. برای استفاده از MaxQDA، ابتدا باید دادههای متنی خود را وارد نرم افزار کنید. سپس میتوانید با استفاده از ابزارهای موجود در نرم افزار، تحلیلهای موردنظر خود را انجام دهید. برای مثال، میتوانید متنها را بر اساس مفاهیم و موضوعات مشترک گروهبندی کنید و تحلیلهای مقایسهای انجام دهید.

NVivo نیز یک نرم افزار تحلیل متن است که به پژوهشگران کمک میکند تا بتوانند از طریق تحلیل متون، الگوها و مفاهیم مختلف را شناسایی کنند. با استفاده از NVivo، میتوانید متون خود را انتخاب کرده و به راحتی برچسبگذاری کنید. سپس با استفاده از ابزارهای موجود در NVivo، میتوانید تحلیلهای مختلفی مانند تجزیه و تحلیل محتوا، تحلیل مفهومی و تحلیل شبکههای اجتماعی را انجام دهید. برای استفاده از NVivo، باید ابتدا پروژهای را ایجاد کنید و سپس متنها و سایر منابع مرتبط را به پروژه اضافه کنید. در ادامه، میتوانید با استفاده از ابزارهای متنی و تحلیلی NVivo، تحلیلهای موردنظر خود را انجام دهید.

با توجه به مطالعه ما در مورد تحلیل متن و اهمیت آن در پژوهشهای علوم انسانی، متوجه شدیم که استفاده از نرم افزارهای تحلیل متن مانند MaxQDA و NVivo می تواند به روش های تحقیقاتی در این زمینه کمک کند. با مقایسه و بررسی این دو نرم افزار، متوجه شدیم که هر یک دارای ویژگی ها و قابلیت های منحصر به فردی هستند که بر اساس نیازهای پژوهشگر می توانند انتخاب شوند. در نهایت، با ارائه راهنمای استفاده از این نرم افزارها، مطمئن شدیم که پژوهشگران می توانند به طور مؤثری از آن ها برای تحلیل و تفسیر داده های متنی خود استفاده کنند. در نتیجه، استفاده از نرم افزارهای تحلیل متن مانند MaxQDA و NVivo می تواند به پژوهشگران در بهبود کیفیت تحقیقات خود کمک کند و باعث افزایش اعتبار و قدرت تفسیری آن ها شود.

استفاده از افزونه فارسی ویراستیار در Word

نوشته

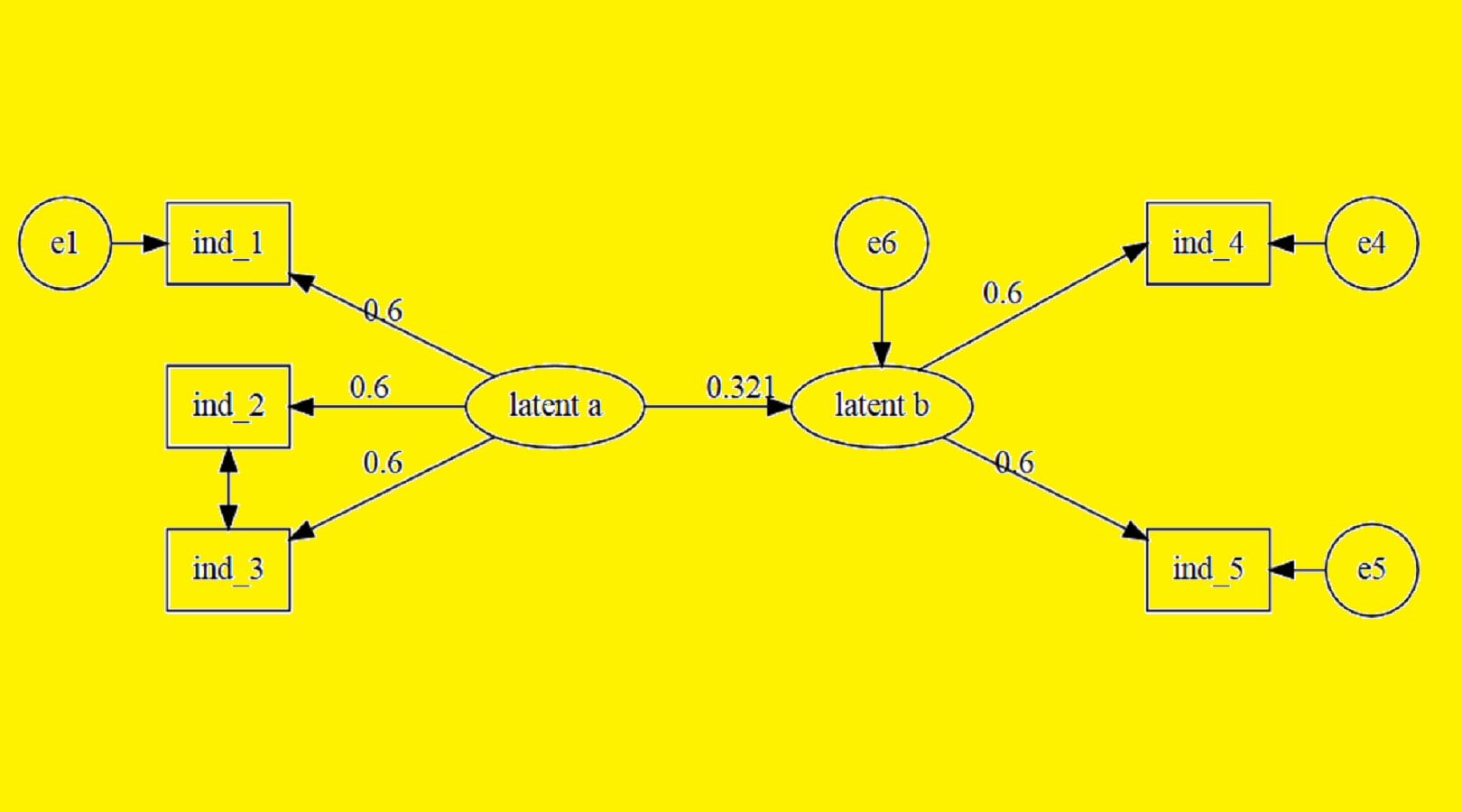

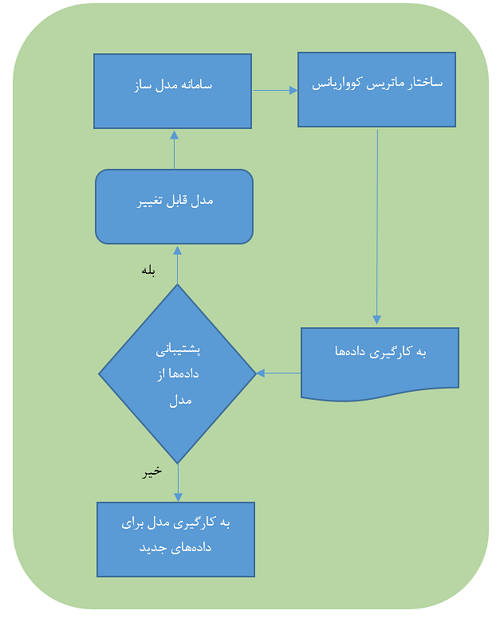

نرم افزار لیزرل و انجام مدلسازی معادلات ساختاری با آن

نوشته

چگونه در ورد متن را بهصورت افقی و یا عمودی قرار دهیم؟!

نوشته

نشریات و مجلات معتبر بین المللی (ISI) در حوزه علوم و تکنولوژی هسته ای

نوشته

نحوه اضافه کردن تصاویر و متن در نرم افزار Word

نرم افزارهای تحلیل متن MaxQDA و NVivo: مقایسه، راهنمای استفاده و اهمیت تحلیل متن در پژوهشهای علوم انسانی