داده کاوی (Data mining) چیست؟ هر آنچه باید در مورد این فناوری بدانید

بسیاری از کسب و کارها و سازمانها دارای اطلاعات خام فراوانی هستند که به کمک داده کاوی میتوانند به اطلاعات نهان، الگوها و روابط مختلف نهفته در دادهها پی ببرند و به کمک آنها، استراتژیهای مختلفی اتخاذ و تصمیمات سنجیدهتری بگیرند.

هوش مصنوعی با استفاده از سرویسهای داده کاوی علاوه بر خوشهبندی و دستهبندی دادهها به مسائلی از قبیل پیشبینی، آنالیز رفتار افراد و تشخیص ناهنجاریها میپردازد. در ادامه این مقاله به بررسی کامل علم داده کاوی پرداخته شدهاست.

داده کاوی چیست؟

داده کاوی فرآیند جستجو در مجموعهای بزرگ از دادهها برای کشف الگوها و روندهایی است که با استفاده از تکنیکهای تجزیهوتحلیل ساده یافت نمیشوند.

IBM در توضیح داده کاوی میگوید این علم نهتنها برای یافتن الگوهای پنهان از دادهها مورد استفاده قرار میگیرد بلکه میتوان از آن برای کشف دانش نهفته در مجموعه دادههای بزرگ، ایجاد مدلهایی که ویژگیهای مربوط به دادهها را توصیف میکنند و نیز پیشبینی بر اساس دادهها بهره گرفت.

همچنین داده کاوی به عنوان کشف دانش در داده (KDD) نیز شناخته میشود. با توجه به تکامل فناوری انبار دادهها و رشد دادههای بزرگ، استفاده از تکنیکهای داده کاوی در چند دهه گذشته به سرعت شتاب گرفته است و با تبدیل دادههای خام به دانش مفید، تصمیمات دقیقتر و بهتری گرفته میشود.

این نکته نیز قابل ذکر است که این فناوری به طور مداوم برای مدیریت دادهها در مقیاس بزرگ تکامل یافته و رشد میکند و مهندسین داده کاوی در تلاش برای حل چالشهای پیش روی خود هستند.

داده کاوی شاخهای از علم آمار است که از الگوریتمهای پیچیدهای استفاده میکند تا در نهایت بتوان برای کسبوکارها جهت جمعآوری اطلاعات خاص از حجم زیاد دادهها و یافتن راهحل برای مشکلات تجاری آنها استفاده کرد. داده کاوی انواع مختلفی دارد که از جمله آنها میتوان داده کاوی تصویری، متن کاوی، استخراج اطلاعات از رسانههای اجتماعی، وب کاوی، و داده کاوی صوتی و تصویری را نام برد.

- آیا QDA Miner قابل استفاده بر روی سیستم عاملهای مختلف است؟

- مراحل تحلیل مضمون آتراید-استرلینگ (Attride-Stirling’s approach)

- آیا اکسل ابزارهایی برای ایجاد داشبوردها و گزارشهای تحلیلی دارد؟

- روغن رزماری و تأثیر چشمگیر آن بر رشد موها + روش استفاده

- 💢دیکتاتور درون و انفجار نادانی

در اوایل دهه ۲۰۰۰، شرکتهای فناوری اطلاعات شروع به مشاهده قدرت داده کاوی کردند. درحالی که عبارت داده کاوی توسط کلمات دیگری مانند “تجزیهوتحلیل دادهها“، “کلان دادهها” و “یادگیری ماشین” تحت الشعاع قرار گرفته است، این فرآیند بخشی جدایی ناپذیر از شیوههای تجاری است.

تاریخچه داده کاوی

دهه نود میلادی و شروع ماجرا

انبار دادهها و فناوریهای تجزیهوتحلیل اطلاعات در اواخر دهه ۱۹۸۰ و اوایل دهه ۱۹۹۰ مطرح شدند و باعث افزایش قدرت تجزیهوتحلیل حجم فزایندهای از دادهها در سازمانها شدند. در طول اولین کنفرانس بینالمللی کشف دانش و داده کاوی در مونترال، نخستینبار اصطلاح داده کاوی در سال ۱۹۹۵ مورد استفاده قرار گرفت.

از سال ۱۹۹۹، این کنفرانس که عموماً با نام KDD نیز شناخته میشود و در درجه اول توسط SIGKDD، گروهی علاقهمند به کشف دانش و داده کاوی در انجمن ماشینهای محاسباتی، سازماندهی شده است این کنفرانس برگزار میشود و تا سه سال آینده نیز همچنان ادامه خواهد داشت.

در دهه گذشته، پیشرفت در قدرت پردازش و سرعت دادهها، انسان را قادر ساخته است تا از شیوههای دستی، خسته کننده و وقتگیر به تجزیهوتحلیل سریع، آسان و خودکار دادهها روی آورد. بر اساس مقالات داده کاوی، پایه و اساس این علم شامل سه رشته علمی درهم تنیده آمار (مطالعه عددی روابط دادهها)، هوشمصنوعی (هوش شبیه به انسان که توسط نرمافزار و/یا ماشینها نمایش داده میشود) و یادگیری ماشین (الگوریتمهایی که میتوانند از دادهها برای پیشبینیها استفاده شوند) است.

یکی از اولین مقالاتی که از عبارت “داده کاوی” استفاده کرد توسط مایکل سی لاول در سال ۱۹۸۳ منتشر شد. در آن زمان، لاول و بسیاری دیگر از اقتصاددانان دیدگاه نسبتاً منفیای نسبت به داده کاوی داشتند و معتقد بودند که آمار میتواند به نتایج نادرست منجر شود.

اما در دهه ۱۹۹۰، ایده استخراج ارزش از دادهها با شناسایی الگوها بسیار محبوب شد. پایگاه دادهها و فروشندگان انبار دادهها برای اجرا کردن نرمافزار خود از عبارت buzz استفاده کردند و شرکتها از مزایای بالقوه این عمل آگاه شدند.

قرن جدید میلادی و استاندارد شدن داده کاوی

در سال ۱۹۹۶، گروهی از شرکتها نظیر Teradata و NCR، پروژهای را برای استانداردسازی و رسمی شدن روشهای داده کاوی هدایت کردند. کار آنها منجر به ایجاد فرآیندی استاندارد برای داده کاوی تحت عنوان (CRISP-DM) شد. این استاندارد، فرآیند داده کاوی را به شش مرحله زیر تقسیم میکند:

- درک کسبوکار

- درک دادهها

- آمادهسازی دادهها

- مدل سازی

- ارزیابی

- گسترش

تلاشهای فراوانی در ترویج مدل CRISP-DM صرف شده است که در نتیجه آن، میتوان به موفقیت IBM در سال ۲۰۱۵ اشاره کرد که نسخه به روز شدهای از گسترش مدل اصلی منتشر نمود.

چرا داده کاوی مهم است؟

داده کاوی روش جمع آوری دادههای بزرگ به منظور شناسایی و بینش آن داده است. امروزه مسیر رشد صنعت داده به سرعت در حال طی شدن است و این امر تقاضا برای تحلیلگران داده و دانشمندان داده را نیز افزایش داده است.

با استفاده از این علم، داده ها را تجزیه تحلیل کرده و سپس دادههای استخراج شده به اطلاعات معنیدار تبدیل میشوند. این به کسبوکارها کمک میکند تا تصمیمات دقیقتر و بهتری درخصوص آینده خود اتخاذ کنند. داده کاوی به توسعه تصمیمگیری هوشمند در بازار، اجرای کمپینهای موثر، پیش بینی و رشد و توسعه کمک میکند.

با استفاده از داده کاوی، میتوان رفتار مشتریان و بینش آنها را تجزیهوتحلیل کرد. این امر منجربه به موفقیت و اثرگذاری در کسبوکارهای مبتنی بر داده میشود.

چالشهای داده کاوی چیست؟

داده کاوی یک علم در حال توسعه و یک راهحل معتبر و قابل اعتماد برای کمک به کسبوکارها در تصمیمگیری است اما این علم نیز بدلیل نوظهور بودن چالشهایی نیز دارد که محققین در حال تلاش برای رفع آنها هستند. چالشها میتوانند مربوط به دادهها و نحوه استخراج آنها، روشها و تکنیکهای مورد استفاده و مواردی از این قبیل باشند. فرآیند داده کاوی زمانی موفقیت آمیز میشود که چالشها یا مسائل به درستی شناسایی شوند و به درستی مدل گرند. در ادامه به تشریح برخی از این چالشها پرداخته شدهاست.

دادههای ناقص و ناهمگن

دادههای دنیای واقعی ناهمگن، ناقص و ناهمگن هستند. دادهها در مقادیر زیاد معمولاً نادرست یا غیرقابل اعتماد هستند. این مشکلات میتواند ناشی از خطاهای ابزار اندازهگیری دادهها یا خطاهای انسانی باشد. فرض کنید یک زنجیره خرده فروشی شناسه ایمیل مشتریانی را که بیش از ۲۰۰ دلار هزینه میکنند جمعآوری میکند و کارکنان صورت حساب جزئیات را در سیستم آنها وارد میکنند. ممکن است فرد هنگام وارد کردن شناسه ایمیل اشتباهات املایی داشته باشد که منجر به تولید دادههای نادرست میگردد. حتی برخی از مشتریان ممکن است آمادگی افشای شناسه ایمیل خود را نداشته باشند که منجر به اطلاعات ناقص خواهدشد. حتی ممکن است دادهها به دلیل خطاهای سیستم یا انسانی تغییر کنند. همه اینها سبب به وجود آمدن دادههای ناهمگن و ناقص میشود که فرآیند داده کاوی را واقعا چالش برانگیز میکند.

داده های توزیع شده

دادههای دنیای واقعی معمولاً در بسترهای مختلف در محیطهای محاسباتی توزیع شده ذخیره می شوند. این میتواند در پایگاههای داده، سیستمهای فردی یا حتی در اینترنت باشد. عملاً به دلایل سازمانی و فنی، جمعآوری همه دادهها به یک پایگاه متمرکز بسیار دشوار است. به عنوان مثال، ممکن است دفاتر مختلف منطقهای سرورهای مخصوص خود را برای ذخیره دادههای خود داشته باشند در حالی که ذخیره تمام دادهها (میلیونها ترابایت) از همه دفاتر در یک سرور مرکزی امکانپذیر نخواهد بود. بنابراین، داده کاوی مستلزم توسعه ابزارها و الگوریتمهایی است که امکان استخراج دادههای توزیع شده را فراهم کند.

داده های پیچیده

دادههای دنیای واقعی واقعاً ناهمگن هستند و میتوانند دادههای چند رسانه ای شامل تصویر، صدا و ویدئو، دادههای پیچیده، دادههای زمانی، دادههای مکانی یا فضایی، سریهای زمانی، متن زبان طبیعی و غیره باشند. مدیریت این انواع دادهها و استخراج اطلاعات مورد نیاز از آنها واقعاً دشوار است. اغلب، ابزارها و روشهای جدیدی برای استخراج اطلاعات مربوطه باید توسعه داده شوند.

کارایی الگوریتمها و تکنیکها

عملکرد سیستم داده کاوی عمدتا به کارآیی الگوریتمها و تکنیکهای مورد استفاده بستگی دارد. اگر الگوریتمها و تکنیکهای طراحی شده در حد مطلوب نباشند، بر عملکرد فرایند داده کاوی تأثیر منفی میگذارد.

ترکیب دانش پیش زمینه

اگر میتوان از دانش پیشین برای حل یک چالش کمک گرفت، راه حلهای داده کاوی معتبرتر و دقیقتر این کار را انجام میدهند. فعالیتهای توصیفی میتوانند یافتههای مفیدتری به دست آورند و کارهای پیشبینی کننده میتوانند پیشبینیهای دقیقتری انجام دهند. اما جمع آوری و گنجاندن دانش پیش زمینه یک فرایند پیچیده است.

تجسم دادهها

تجسمداده یک فرایند بسیار مهم در داده کاوی است زیرا این فرایند اصلی خروجی را به نحوی قابل نمایش برای کاربران به نمایش میگذارد. اطلاعات استخراج شده باید معنای دقیق آنچه را که قصد انتقال آن را دارند منتقل کنند. اما در بسیاری از موارد، ارائه اطلاعات به روشی دقیق و آسان برای کاربر نهایی واقعاً دشوار است.

حریم خصوصی و امنیت

داده کاوی به طور معمول منجر به ایجاد چالشهایی جدی از نظر امنیت دادهها، حریم خصوصی و مسائل دولتی میشود. به عنوان مثال، هنگامی که یک خرده فروش جزئیات خرید را تجزیه و تحلیل میکند ، اطلاعات مربوط به عادات خرید و ترجیحات مشتریان را بدون اجازه آنها فاش میکند، و یا در خصوص تحلیل دادههای مالی نیز باید برخی دادههای محرمانه از حساب کاربری افراد گردآوری شود که از منظر امنیتی مشکلاتی را ایجاد میکند.

مزایای داده کاوی برای کسبوکارها چیست؟

در ادامه به تشریح تنها برخی از مزایای داده کاوی و کشف دانش از دادهها پرداخته شدهاست.

- با کمک داده کاوی، شرکتهای بازاریابی مدل دادهها و پیشبینیهای خود را بر اساس دادههای تاریخی ایجاد میکنند. آنها در صورت لزوم کمپینها و استراتژیهای بازاریابی داده محور را اجرا کرده که این امر باعث موفقیت و رشد سریع در کسبوکار آنها میشود.

- صنعت خرده فروشی نیز با شرکتهای بازاریابی در یک سمتوسو قرار دارد. با داده کاوی، آنها به مدلهای مبتنی بر دادهها برای پیشبینی خریدوفروش کالاها و خدمات خود میرسند؛ لذا میتوانند سبب افزایش سود در کار خود شوند.

- داده کاوی به بانکها در تجزیهوتحلیل دادههای مالی و بهروز رسانی اطلاعات خود از رفتار مشتریانشان کمک میکند. همچنین از داده کاوی برای ارزیابی مشتریان و اعتبار سنجی آنها در زمان اعطای وام بهره میگیرند.

- تولیدکنندگان از داده کاوی در بررسی دادههای مهندسی و تشخیص دستگاهها و محصولات معیوب بهره میبرند. داده کاوی به آنها کمک میکند تا علل ایجاد خرابی و مشکل در سیستم را کشف کرده و آن را رفع نمایند.

- داده کاوی به دستگاههای دولتی کمک میکند تا دادهها و اطلاعات مالی خود را تجزیهوتحلیل کنند. همچنین در شناسایی رفتار اربابرجوع و تحلیل نیازهای افراد نیز به آنها یاری میرساند.

- سازمانها میتوانند از داده کاوی برای بهبود در برنامهریزی و تصمیمگیریهایشان کمک کند.

- داده کاوی سبب ایجاد جریانهای جدید درآمدی در سازمانها می شود که رشد آنها را تسریع میکند.

- داده کاوی به کسبوکارها و سازمانها در جهت توسعه خدمات و محصولات جدید نیز یاری میرساند.

- افزایش شناخت مشتریان سبب ایجاد تعاملات بهتر با آنها و در نتیجه احساس رضایت بیشترشان میگردد.

- پس از ایجاد مزایای رقابتی، هزینه نیز با کمک داده کاوی کاهش می یابد.

فرآیند داده کاوی چیست؟

تکنیکهای داده کاوی توسط دانشمندان داده و دیگر متخصصان ماهر هوش تجاری برای ایجاد، توصیف و پیشبینی در مورد مجموعه دادهها استفاده میشود. فرآیند داده کاوی شامل چندین مرحله از جمعآوری دادهها تا تصویرسازی اطلاعات ارزشمند از مجموعه دادههای بزرگ است.

عناصر اصلی کشف دانش از داده؛ یادگیری ماشین و تجزیهوتحلیل آماری را شامل میشود که مدیریت داده و آماده سازی آنها جهت تجزیهوتحلیل را نیز در بر میگیرد. استفاده از الگوریتمهای یادگیری ماشین و ابزارهای هوشمصنوعی بیشتر فرآیند را خودکار کرده و استخراج مجموعه دادههای عظیم، همچون پایگاه دادههای مشتری، سوابق تراکنشها و فایلهای ورود به سیستم از وب سرورها، برنامههای تلفن همراه و حسگرها را آسانتر کرده است.

فرآیند داده کاوی را میتوان به چهار مرحله اصلی تقسیم کرد که در ادامه به شرح آنها پرداخته شده است:

تعیین اهداف تجاری

قبل از شروع، باید درک کاملی از اهداف شرکت یا سازمان، منابع موجود و سناریوهای فعلی شرکت یا سازمان در راستای حل چالشها کسب کرد. این امر به ایجاد یک برنامه داده کاوی دقیق کمک میکند که بتوان بواسطه آن به طور موثر به اهداف سازمان دست پیدا کرد. بر خلاف تصورات، این مرحله میتواند سختترین قسمت فرآیند داده کاوی باشد، اما بسیاری از سازمانها زمان بسیار کمی را صرف آن میکنند. دانشمندان داده و ذینفعان کسبوکار باید برای تعریف مشکل کسبوکار با یکدیگر همکاری کنند تا بتوان پارامترهای مورد نیاز برای فرآیند داده کاوی برای یک پروژه معین را مشخص کرد. همچنین ممکن است تحلیلگران برای درک مناسب زمینه کسبوکار نیاز به تحقیقات بیشتری داشته باشند.

آماده سازی دادهها

این مرحله شامل مجموعهای از مراحل آمادهسازی دادهها برای استخراج است. این کار با اکتشاف دادهها، پروفایل و پیش پردازش شروع میشود و پس از آن کار پاکسازی دادهها برای رفع خطاها و سایر مسائل مربوط به کیفیت داده انجام میگردد. با جمعآوری دادهها از منابع مختلف، باید آنها را بررسی کرد تا هرگونه نویز مانند موارد تکراری، مقادیر مفقود شده و نقاط پرت را حذف کرد. تبدیل دادهها برای سازگاری مجموعه دادهها نیز در این مرحله انجام میشود، مگر اینکه یک دانشمند داده به دنبال تجزیهوتحلیل دادههای خام بدون فیلتر برای یک برنامه خاص باشد.

برخی از مقالات داده کاوی بر این باورند که بیشترین زمان در فرآیند داده کاوی در این بخش صرف میگردد. هنگامی که محدوده مشکل مشخص شد، برای دانشمندان داده آسانتر است که تشخیص دهند کدام مجموعه دادهها به سوالات مربوط به کسبوکار پاسخ میدهد.

مدلسازی و الگوکاوی

در این مرحله برای شناسایی بهتر الگوهای داده، چندین مدل ریاضی بر اساس شرایط مختلف در مجموعه داده اجرا میشود که بسته به نوع تجزیهوتحلیل، دانشمندان داده میتوانند هر گونه رابطه موجود بین دادهها نظیر الگوهای متوالی، قوانین ارتباط یا همبستگی را بررسی کنند. در حالی که الگوهایی با تکرار بیشتر کاربردهای وسیعتری دارند، گاهی اوقات انحراف در دادهها نیز میتواند جالب باشد چراکه به عنوان مثال میتوان زمینههای کلاهبرداری احتمالی را برجسته کرد.

بسته به دادههای موجود، الگوریتمهای یادگیری عمیق نیز ممکن است برای طبقه بندی یا دسته بندی مجموعه دادهها استفاده شود. اگر دادههای ورودی دارای برچسب باشند (یعنی یادگیری تحت نظارت)، ممکن است از یک مدل طبقه بندی برای دسته بندی دادهها استفاده شود، یا به طور متناوب، برای پیشبینی احتمال یک مسئله خاص، از رگرسیون استفاده شود و اگر مجموعه دادهها برچسب گذاری نشده باشند (یعنی یادگیری بدون نظارت)، دادهها به صورت انفرادی در مجموعه آموزش با یکدیگر مقایسه میشوند تا شباهتهای اساسی را کشف کرده و آنها را بر اساس آن ویژگیها طبقه بندی کرد.

ارزیابی نتایج و پیادهسازی دانش

نتایج داده کاوی برای ایجاد مدلهای تحلیلی استفاده میشود که میتواند به تصمیمگیری و سایر اقدامات تجاری کمک کند. پس از جمعآوری دادهها، نتایج باید ارزیابی و تفسیر شوند. هنگام نهایی شدن نتایج، آنها باید معتبر، بدیع، مفید و قابل درک باشند. هنگامی که این معیارها برآورده میشوند، سازمانها میتوانند از این دانش برای اجرای استراتژیهای جدید و دستیابی به اهداف مورد نظر خود استفاده کنند.

انواع دادههای قابل استخراج

دادههای ذخیره شده در پایگاه داده

به پایگاه داده، سیستم مدیریت پایگاه داده یا DBMS نیز گفته میشود. هر DBMS دادههای مربوطه را به نحوی ذخیره میکند. همچنین دارای مجموعهای از برنامههای نرمافزاری است که برای مدیریت دادهها و دسترسی آسان به آنها استفاده میشود. این برنامههای نرمافزاری اهداف زیادی را ارائه میدهندکه از جمله آنها تعریف ساختار پایگاه داده، اطمینان از امنیت و ثبات اطلاعات ذخیره شده و مدیریت انواع مختلف دسترسی به دادهها نظیر اشتراکگذاری و توزیع را میتوان نام برد.

انبار داده

انبار داده یک محل واحد جهت ذخیره داده است که دادهها را از منابع مختلف جمعآوری کرده و سپس در قالب یک طرح واحد ذخیره میکند. هنگامی که دادهها در یک انبار داده ذخیره میشوند، ابتدا باید یکپارچه و بهروزرسانی شوند. دادههای ذخیره شده در انبار دادهها در چندین قسمت سازماندهی میشوند.

دادههای معاملاتی

پایگاه داده معاملاتی پروندههایی را ذخیره میکند که به عنوان تراکنش ثبت میشوند. این معاملات شامل مواردی چون رزرو پرواز، خرید مشتری، کلیک روی وب سایت و موارد دیگر است. هر پرونده تراکنش دارای یک شناسه منحصر به فرد است. همچنین میتوان تمامی مواردی که باعث معامله شده است را در این پایگاه داده فهرست نمود.

انواع دیگر دادهها

مجموعهای زیادی از دادهها وجود دارند که نوع آنها با توجه به ساختار، معانی و تطبیقپذیری تعیین میگردند. این دادهها در بسیاری از برنامهها استفاده میشوند. از جمله آنها میتوان به جریان دادهها، دادههای طراحی مهندسی، دادههای توالی، دادههای نمودار، دادههای فضایی و دادههای چند رسانهای اشاره کرد.

داده کاوی با پایتون

در دنیای امروز که دادهها نقش اصلی را ایفا میکنند، جمعآوری بینش از آنها مهم است. تکنیکهای داده کاوی راه را برای برنامه نویسان جهت یافتن این بینشها هموار میکند. پایتون محبوب ترین زبان برنامه نویسی است که انعطاف پذیری و قدرت برنامه نویسان و دانشمندان داده را برای انجام تجزیهوتحلیل دادهها و اعمال الگوریتمهای یادگیری ماشین ارائه می دهد. در سالهای اخیر، پایتون به دلیل افزایش تعداد کتابخانههای تجزیهوتحلیل داده برای داده کاوی از محبوبیت بیشتری برخوردار شده است. از جمله دلایل استفاده برنامه نویسان داده کاوی از پایتون به شرح زیر است:

- کار کردن با پایتون ساده است.

- تعداد و تنوع کتابخانهها در پایتون زیاد میباشد.

- داده کاوی در پایتون بسیار پرکاربرد است.

- امکان پیادهسازی و استفاده پایتون در اکثر سیستم عاملها وجود دارد

همچنین بعنوان مزایای داده کاوی در پایتون میتوان موارد زیر را نیز نام برد:

- وجود تحلیلهای آماری ساده و پیشرفته

- وارد کردن انواع دادهها با فرمتهای مختلف

- توانایی پردازش دادهها با حجم زیاد

- پیش پردازش دادهها

- تصویرسازی دادهها در پایتون

- پیادهسازی الگوریتمهای یادگیری ماشین

- ماتریس درهم ریختگی و ارزیابی مدل

پلتفرمهای داده کاوی

داده کاوی یک فضای تخصصی در زمینه تجزیهوتحلیل دادهها است و فعالیتی است که یک کسبوکار برای یافتن اطلاعات معنادار از تمام منابع دادهای که میتواند به طور خالص به عنوان دادههای خام ارائه دهد، با استفاده از تکنیکهای هوشمند و علمی، که الگوریتم نیز نامیده میشود، انجام میدهد.

با تصویرسازی داده کاوی به عنوان یک ماشین، دادههای خام تبدیل به ورودی میشوند، فعالیت داده کاوی به وظیفهای که دستگاه برای انجام آن طراحی شده است تبدیل میشود و خروجی از دستگاه دادههای قابل اجرا است. به عبارت دیگر، دادههایی که میتوانند برای تهیه راهبردی یا تصمیمات تاکتیکی، تأثیر مثبتی بر نتیجه نهایی بگذارند. پلتفرمهای موجود برای اجرای روشها و تکنیکهای مختلف مورد استفاده در داده کاوی استفاده میشود.

در اینجا پیرامون این پلتفرمها و کتابخانههای داده کاوی صحبت میکنیم که تنها به عنوان نمونهای از پلتفرمهای قابل اجرا برای تکنیک های داده کاوی استفاده میشوند. پلتفرمهای داده کاوی برنامههای نرمافزاری هستند که به چارچوب بندی و اجرای تکنیکهای داده کاوی برای ایجاد مدل و آزمایش آنها کمک میکنند. معمولاً یک چارچوب مانند R studio یا Tableau مجموعهای از برنامهها هستند که به ساخت و آزمایش مدل داده کمک میکنند.

ابزارهای زیادی در بازار متن باز و اختصاصی با سطوح مختلف پیچیدگی وجود دارد. در اصل، هر ابزار به اجرای یک استراتژی داده کاوی کمک میکند، اما تفاوت در سطح پیچیدگی آنها، مشتری این نرم افزارها را تعیین میکند. ابزارهایی وجود دارند که در حوزه خاصی مانند حوزه مالی به خوبی عمل میکنند.

ابزارهای مفید بسیاری برای داده کاوی وجود دارد که در ادامه لیستی از ۲۵ نرم افزار داده کاوی انتخاب شده و ارائه شده است:

| ردیف | نام ابزار/ پلتفرم/کتابخانه | لینک دانلود و اطلاعات بیشتر |

| ۱ | SAS Data mining | https://www.sas.com/en_us/insights/analytics/data-mining.html |

| ۲ | Teradata | https://www.teradata.in/Products/Cloud/IntelliCloud |

| ۳ | R-Programming | https://www.r-project.org |

| ۴ | BOARD | https://www.board.com/en |

| ۵ | Dundas | http://www.dundas.com/support/dundas-bi-free-trial |

| ۶ | Inetsoft | https://www.inetsoft.com/products/StyleIntelligence |

| ۷ | H2O | https://www.h2o.ai |

| ۸ | Qlik | https://www.qlik.com/us/products/qlik-sense |

| ۹ | RapidMiner | https://my.rapidminer.com/nexus/account/index.html |

| ۱۰ | Oracle BI | https://orange.biolab.si |

| ۱۱ | KNIME | https://www.knime.com/software-overview |

| ۱۲ | Tanagra | https://eric.univ-lyon2.fr/~ricco/tanagra/en/tanagra.html |

| ۱۳ | Solver | https://www.solver.com/xlminer-data-mining |

| ۱۴ | Sisense | https://www.sisense.com |

| ۱۵ | Data Melt | https://jwork.org/dmelt |

| ۱۶ | ELKI | https://elki-project.github.io |

| ۱۷ | SPMF | http://www.philippe-fournier-viger.com/spmf |

| ۱۸ | Alteryx | https://www.alteryx.com |

| ۱۹ | Enterprise Miner | https://www.sas.com/en_us/software/enterprise-miner.html |

| ۲۰ | Datawatch | https://www.altair.com/panopticon |

| ۲۱ | Advanced miner | https://algolytics.com/products/advancedminer |

| ۲۲ | Analytic Solver | https://www.solver.com/products-overview |

| ۲۳ | PolyAnalyst | https://www.megaputer.com/polyanalyst |

| ۲۴ | Civis | https://www.civisanalytics.com/civis-platform |

| ۲۵ | Viscovery | https://www.viscovery.net/somine |

انواع تکنیکهای داده کاوی چیست؟

هر یک از تکنیکهای داده کاوی جهت حل مشکل تجاری متفاوتی مطرح شدهاند و بینش خاصی را ارائه میدهند. با آگاهی از نوع مشکل میتوان روش داده کاوی مناسبی را جهت دستیابی به بهترین نتایج انتخاب نمود. بر اساس برخی مقالههای داده کاوی در دنیای دیجیتال امروز، بشر با دادههای بزرگی احاطه شده که پیشبینی میشود این مقدار در دهه آینده ۴۰ درصد در سال رشد خواهد کرد. در ادامه، ۵ تکنیک داده کاوی جهت دستیابی به نتایج مطلوب ارائه گردیده است.

تجزیهوتحلیل خوشهبندی

خوشه در واقع مجموعهای از اشیاء داده است که این دادهها در یک خوشه مشابه هستند. این بدان معناست که اشیاء مشابه یکدیگر در یک گروه هستند و با اجسام گروههای دیگر یا در خوشههای دیگر نسبتا بیشباهت یا بیارتباط هستند. تجزیه خوشهای فرآیند کشف گروهها و خوشهها در دادهها به گونهای است که میزان ارتباط بین دو شیء در صورتی که متعلق به یک گروه باشند بیشترین میزان را دارد و در غیر این صورت کمترین ارتباط را دارند. برای مثال نتیجه این تجزیهوتحلیل میتواند برای ایجاد پروفایل مشتریان و دستهبندی آنها استفاده شود.

تجزیهوتحلیل طبقهبندی

این تجزیهوتحلیل برای بازیابی اطلاعات مهم و مرتبط در مورد دادهها و فرادادهها و همچنین برای طبقهبندی دادههای گوناگون در کلاسهای مختلف استفاده میشود. طبقهبندی شبیه خوشهبندی است به گونهای که پروندههای داده را نیز به بخشهای مختلف به نام کلاس تقسیم میکند. اما بر خلاف خوشهبندی، در اینجا تحلیلگران داده از کلاسها یا خوشههای مختلف آگاهی دارند. بنابراین، در تجزیهوتحلیل طبقهبندی فرد از الگوریتمهایی برای تصمیمگیری در مورد نحوه طبقهبندی دادههای جدید استفاده میکند. یک مثال کلاسیک از تجزیهوتحلیل طبقه بندی، ایمیل Outlook است. در Outlook، افراد از الگوریتمهای خاصی برای مشخص کردن اینکه آیا ایمیل ورودی قانونی است و یا هرزنامه استفاده میکنند.

یادگیری قانون مشارکتی

این تکنیک به روشی اشاره میکند که میتواند به افراد در شناسایی برخی از روابط (مدل سازی وابستگی) بین متغیرهای مختلف در پایگاههای داده بزرگ کمک کند. یادگیری قانون مشارکتی میتواند در کشف برخی الگوهای پنهان در دادهها جهت شناسایی متغیرها در یک مجموعه داده استفاده شود.. به عنوان مثال از یادگیری قانون مشارکتی میتوان برای بررسی و پیشبینی رفتار مشتری استفاده کرد که در تجزیهوتحلیل صنعت خرده فروشی بسیار کاربرد دارد. این تکنیک برای تعیین تجزیهوتحلیل دادههای سبد خرید، دستهبندی محصولات، طراحی کاتالوگ و چیدمان فروشگاه استفاده میشود.

تشخیص ناهنجاری یا دادههای پرت و تغییرات

این تکنیک به بررسی میزان تطابق دادهها در یک مجموعه داده با الگوی یا رفتار مورد انتظار میپردازد و دادههای پرت و یا ناهنجار در آنها را شناسایی میکند. ناهنجاری عبارت است از انحراف قابل توجهی از میانگین رایج در یک مجموعه داده یا ترکیبی از دادهها. این نوع اقلام در مقایسه با بقیه دادهها از نظر آماری دور هستند و از این رو نشان میدهد که اتفاقی غیر عادی رخ داده است و نیاز به توجه بیشتری دارد. این تکنیک میتواند در حوزههای مختلف مانند تشخیص عامل مخرب در سیستم، مورد استفاده قرار گیرد. نظارت بر سلامت، تشخیص تقلب، تشخیص خطا، تشخیص رویداد در شبکههای حسگر و تشخیص اختلالات اکوسیستم از کاربردهای رایج این تکنیک هستند که در آن تحلیلگران غالباً دادههای غیر عادی را از مجموعه دادههای کشف شده با دقت بیشتری حذف میکنند.

تجزیهوتحلیل رگرسیون

از نظر آماری، تحلیل رگرسیون فرآیند شناسایی و تجزیهوتحلیل رابطه بین متغیرها است. اگر متغیر مسئله متغیری مستقل باشد، میتواند به تحلیلگر در درک مقدار مشخص تغییرات متغیر وابسته کمک کند لذا به طور کلی میتوان از تجزیهوتحلیل رگرسیون برای پیشبینی یک عامل در آینده استفاده نمود.

همه این تکنیکها میتوانند به تجزیهوتحلیل دادههای مختلف از دیدگاههای گوناگون کمک کنند. داده کاوی تکنیکها و روشهای دیگری نیز دارد که در جدول زیر تنها به آنها اشاره شده است.

| ۱ | استخراج عامل | Agent mining |

| ۲ | تشخیص ناهنجاری/ دادههای پرت/ تغییرات | Anomaly/outlier/change detection |

| ۳ | یادگیری قانون مشارکتی | Association rule learning |

| ۴ | شبکههای بیزی | Bayesian networks |

| ۵ | طبقه بندی | Classification |

| ۶ | تحلیل خوشه | Cluster analysis |

| ۷ | درختهای تصمیم | Decision trees |

| ۸ | یادگیری گروهی/ جمعی | Ensemble learning |

| ۹ | تجزیهوتحلیل فاکتورها | Factor analysis |

| ۱۰ | الگوریتمهای ژنتیک | Genetic algorithms |

| ۱۱ | استخراج تصمیم | Intention mining |

| ۱۲ | یادگیری سیستمهای طبقه بندی | Learning classifier system |

| ۱۳ | یادگیری چند سطحی شبه فضا | Multilinear subspace learning |

| ۱۴ | شبکههای عصبی | Neural networks |

| ۱۵ | تحلیل رگرسیون | Regression analysis |

| ۱۶ | دنباله کاوی | Sequence mining |

| ۱۷ | تجزیهوتحلیل دادههای ساختاریافته | Structured data analysis |

| ۱۸ | ماشینهای بردار پشتیبان | Support vector machines |

| ۱۹ | متن کاوی | Text mining |

| ۲۰ | تحلیل سریهای زمانی | Time series analysis |

انواع الگوریتمهای داده کاوی

الگوریتمهای داده کاوی جهت پیادهسازی تکنیکهای اشاره شده در بخش قبل، مطرح شدهاند. تعداد این الگوریتمها بسیار زیاد است و هر روزه مقالههای جدیدی در این خصوص انتشار مییابد. در ادامه به شرح ۱۰ الگوریتم برتر که بیشترین استفاده را دارند، پرداخته شده است.

الگوریتم C۴.۵

C4.5 یکی از برترین الگوریتمهای داده کاوی است و توسط راس کوینلان توسعه داده شده است. C4.5 برای ایجاد یک طبقهبندی کننده در قالب یک درخت تصمیم از مجموعه دادههایی که قبلاً طبقهبندی شده است، استفاده میشود. طبقهبندی کننده در اینجا به یک ابزار داده کاوی اشاره دارد که دادههایی را که برای طبقهبندی آنها نیاز است میگیرد و سعی میکند کلاس دادههای جدید را پیشبینی کند.

هر نقطه داده ویژگیهای خاص خود را دارد. درخت تصمیم ایجاد شده توسط C4.5 سوالی در مورد ارزش یک ویژگی ایجاد میکند و بسته به آن مقادیر، دادههای جدید طبقهبندی میشوند. مجموعه دادههای آموزشی دارای برچسبهایی است که C4.5 را به یک الگوریتم یادگیری تحت نظارت تبدیل میکند.

الگوریتم k-means

یکی از رایج ترین الگوریتمهای خوشهبندی، k-means است که با ایجاد k گروه از مجموعهای از دادهها و بر اساس شباهت بین دادههای درون مجموعه عمل میکند. ممکن است تضمین نشود که اعضای گروه دقیقاً مشابه هم هستند، اما اعضای گروه در مقایسه با اعضای غیر گروهی بیشتر شبیه به هم خواهند بود. طبق پیاده سازیهای استاندارد، k-mean یک الگوریتم یادگیری بدون نظارت است زیرا خوشه را به تنهایی و بدون هیچ گونه اطلاعات خارجی یاد میگیرد.

الگوریتم Support Vector Machines

از منظر وظایف، ماشین بردار پشتیبان (SVM) مشابه الگوریتم C4.5 عمل میکند با این تفاوت که SVM به هیچ وجه از هیچ درخت تصمیم گیری استفاده نمیکند. SVM مجموعه دادهها را میآموزد و یک ابرصفحه برای طبقه بندی دادهها در دو کلاس تعریف میکند. ابر صفحه معادلهی خطی مشابه با “y = mx + b” است. SVM به کمک توابع ریاضی دادهها را به ابعاد بالاتر نگاشت میدهد. این تکنیک پس از طراحی، بهترین ابرصفحه را برای تفکیک دادهها به دو کلاس تعریف میکند.

الگوریتم Apriori

الگوریتم Apriori با یادگیری قانون مشارکتی کار میکند. همانطور که پیش از این اشاره شد، قانون مشارکتی یک تکنیک داده کاوی است که برای یادگیری ارتباط بین متغیرها در پایگاه داده استفاده میشود. هنگامی که قوانین مشارکتی آموخته میشود، روی پایگاه دادهای که شامل تعداد زیادی تراکنش است، اعمال میشود. الگوریتم Apriori برای کشف الگوهای جالب و روابط متقابل استفاده میشود و بنابراین به عنوان یک روش یادگیری بدون نظارت رفتار شناخته میشود. این الگوریتم حافظه زیاد و فضای زیادی از دیسک را استفاده میکند و نسبتا زمانبر است.

الگوریتم Expectation-Maximization

Expectation-Maximization یا به اختصار EM به عنوان یک الگوریتم خوشهبندی، درست مانند الگوریتم k-means برای کشف دانش استفاده میشود. الگوریتم EM در تکرارهای مختلف اجرا میشود تا شانس کشف دادههای مشاهده شده را بهینه کند. سپس، پارامترهای مدل آماری را با متغیرهای مشاهده نشده برآورد میکند، در نتیجه برخی دادههای مشاهده شده را تولید میکند. الگوریتم EM نیز از نوع یادگیری بدون نظارت است زیرا از آن بدون ارائه اطلاعات کلاس برچسبگذاری شده استفاده میشود.

الگوریتم PageRank

الگوریتم PageRank که توسط دانشگاه استنفورد ثبت شده، معمولاً توسط موتورهای جستجو مانند گوگل استفاده میشود. این یک الگوریتم تجزیهوتحلیل پیوند است که اهمیت نسبی یک شی را در شبکه ای از اشیای متصل، تعیین میکند. بنابراین میتوان گفت که تجزیهوتحلیل پیوند نوعی تجزیهوتحلیل شبکه است که ارتباط بین اشیاء را بررسی میکند. جستجوی گوگل با درک پیوندهای بین صفحات وب از این الگوریتم استفاده میکند. PageRank به عنوان یک روش یادگیری بدون نظارت تلقی میشود زیرا اهمیت نسبی را فقط با در نظر گرفتن پیوندها تعیین میکند و به ورودیهای دیگری نیاز ندارد.

الگوریتم AdaBoost

AdaBoost یک الگوریتم تقویتکننده است که برای انجام طبقهبندی استفاده میشود. الگوریتم AdaBoost یک الگوریتم یادگیری گروهی است که چندین الگوریتم یادگیری را اجرا کرده و آنها را ترکیب میکند.

الگوریتمهای تقویت، گروهی از یادگیرندگان ضعیف را در بر می گیرد و آنها را با یکدیگر ترکیب میکند تا یک یادگیرنده قوی بسازد. یک یادگیرنده ضعیف دادهها را با دقت کمتر طبقهبندی میکند. بهترین مثال از یک الگوریتم ضعیف، الگوریتم تصمیم است که اساساً یک درخت تصمیم یک مرحله ای است. Adaboost یادگیری تحت نظارت کامل است زیرا در تکرارهای مختلف، یادگیرنده ضعیفتر را با مجموعه داده برچسب زده آموزش میدهد.

پس از مشخص شدن تعداد دور توسط کاربر، در تکرارهای پیدرپی AdaBoost وزنها را برای هر یک از بهترین یادگیرندگان دوباره تعریف میکند. این امر Adaboost را به راهکاری مناسب جهت تنظیم خودکار طبقهبندی تبدیل میکند. Adaboost انعطاف پذیر و کاربردی است زیرا میتواند بیشتر الگوریتمهای یادگیری را در خود جای دهد و دادههای متنوعی را به خود اختصاص دهد. پیادهسازی ساده Adaboost از مزایای دیگر این الگوریتم است.

الگوریتم kNN

الگوریتم kNN اصطلاحا یک الگوریتم یادگیری تنبل است که به عنوان الگوریتم طبقهبندی استفاده میشود. یک یادگیرنده تنبل در طول فرآیند آموزش به جز ذخیره دادههای آموزشی، کار خاصی انجام نمیدهد. یادگیرندگان تنبل فقط زمانی طبقه بندی را شروع میکنند که دادههای جدید بدون برچسب به عنوان ورودی داده شوند. از سوی دیگر، C4.5، SVN و Adaboost، الگوریتمهای یادگیری کوشا هستند که در طول آموزش شروع به ایجاد مدل طبقه بندی میکنند. از آنجا که kNN از یک مجموعه داده آموزشی برچسب زده شده استفاده مینماید، به عنوان یک الگوریتم یادگیری تحت نظارت در نظر گرفته میشود.

الگوریتم Naive Bayes

Naive Bayes یک الگوریتم واحد نیست، اگرچه میتوان آن را به عنوان یک الگوریتم واحد مشاهده کرد. Naive Bayes مجموعهای از الگوریتمهای طبقهبندی است که در کنار هم قرار گرفته اند. فرض مورد استفاده Naive Bayes این است که همه ویژگیهای دادههای طبقهبندی شده مستقل از همه ویژگیهای دادههای دیگری که در کلاس ارائه شده است باشد. Naive Bayes دارای یک مجموعه داده آموزشی با برچسب برای ساخت جداول است. بنابراین به عنوان یک الگوریتم یادگیری تحت نظارت رفتار میکند.

الگوریتم CART

الگوریتم CART مخفف درختان طبقه بندی و رگرسیون است. این یک الگوریتم یادگیری درخت تصمیم است که رگرسیون و یا طبقهبندی درختان را به عنوان خروجی ارائه می دهد. در CART، گرههای درخت تصمیم دقیقاً ۲ شاخه خواهند داشت. ماشبه با C4.5، CART نیز یک طبقهبندیکننده است. مدل درخت رگرسیون یا طبقهبندی با استفاده از مجموعه داده آموزشی دارای برچسب ارائه شده توسط کاربر، ساخته میشود. از این رو به عنوان یک تکنیک یادگیری تحت نظارت رفتار میکند.

کاربردهای داده کاوی

براساس آنچه گفته شد داده کاوی روشی برای استخراج دادهها از منابع متعدد و سازماندهی آنها برای به دست آوردن بینشهای ارزشمند است. بدون شک، ادامه حیات شرکتهای امروزی بدون تحلیل دادهها بسیار دشوار خواهد بود. نیاز به تکامل و همراستایی با تکنولوژی و روندهای دیجیتالی آینده، از پیشنیازهای بقا در بازار رقابتی امروز است. حال در ادامه برای روشن شدن بهتر کاربردهای داده کاوی در صنایع مختلف، برخی از آنها شرح داده شده است.

داده کاوی در پزشکی

صنعت سلامت و پزشکی یکی از مهمترین بخشهای زندگی بشر است. داده کاوی با کشف دانش از میان انبوه زیادی از دادههای مرتبط با سوابق بیماران و بیماری آنها، درک روابط و قوانین حاکم بر این دادهها را میسر میسازد. تجزیهوتحلیل این دادهها اطلاعات ارزشمندی در جهت شناسایی دلایل بیماریها، تشخیص، پیشبینی و درمان آنها در اختیار متخصصان و دانشمندان حوزه سلامت و پزشکی قرار میدهد. حجم دادههای تولید شده در این صنعت با گذر زمان افزایش زیادی یافته است و دیگر تحلیل آنها کاری که بتوان به صورت دستی انجام داد نیست. از طرف دیگر، با توجه به ضرورت انجام این کار هرروزه دانشمندان و متخصصان بیشتری به سمت استفاده از تکنیکها و روشهای داده کاوی در صمهت پزشکی روی میآورند. از جمله کاربردهای داده کاوی در این صنعت را میتوان در ادامه مطالعه کرد:

- تحلیل اطلاعات حاصل از میزان تاثیر دارو بر بیماری و اثرات جانبی آن

- کشف رابطه بین تاثیر دارو بر روی افراد مختلف به لحاظ عواملی چون سن، جنسیت، ژن و سبک زندگی

- تشخیص و پیشبینی بیماریها بر اساس علائم ظاهر شده با توجه به نمونههای پیشین

- کمک در مشخص کردن مسیر درمان

- پیشبینی میزان تاثیرگذاری اقدامات پزشکی در مواردی مانند عملهای جراحی

- تجزیهوتحلیل تصاویر پزشکی

- کمک در کشف تقلب و سوء استفاده به بیمهگذاران مراقبتهای بهداشتی

بر اساس گزارشات و مقالات داده کاوی که اخیرا منتشر شدهاست، میتوان انتظار داشت که این فناوری در کاهش هزینههای درمانی نیز مؤثر واقع شود. همچنین، اگر پروژههای کلان داده و داده کاوی با هدف بهبود کارایی و کیفیت استفاده شوند، ارزش آنها میتواند به بیش از ۵۰۰ میلیارد دلار در سالهای آینده برسد. لذا به طور کلی، میتوان گفت که به کمک داده کاوی در آینده سطح مراقبتهای بهداشتی افزایش چشمگیری پیدا خواهند کرد. در انتها این نکته نیز قابل ذکر است که در دوران شیوع پاندمی کرونا نیز داده کاوی کمکهای فراوانی به تشخیص بیماران و افراد سالم، درمان و مواردی از این قبیل کرد.

داده کاوی در شبکههای اجتماعی

رسانههای اجتماعی در گذشته صرفاً به عنوان بسترهای ارتباطی شروع به کار کردند که این فرایند عملکرد ساده ای داشت: تعامل بین دوستان، خانوادهها و حتی غریبهها از طریق اینترنت. اما امروزه دیگر رسانههای اجتماعی به این سادگی نیستند. از آنجا که داشتن حداقل یک یا چند حساب رسانه اجتماعی برای بسیاری از افراد به یک ضرورت تبدیل شده است، درها نیز به روی مشاغل باز شده است.

داده کاوی در این زمینه شامل جمعآوری اطلاعات تولید شده توسط کاربران در بستر رسانههای اجتماعی است. هدف از استخراج دادههای رسانههای اجتماعی بدست آوردن دادههای ارزشمند از از تحلیل رفتار مصرفکنندگان، شناسایی الگوها و روندها و در نتیجه بهبود کسبوکارهای اینترنتی است.

داده کاوی شبکههای اجتماعی فرآیند استخراج عناصر گرانبهایی است که بیشتر آنها آشکار نبوده و به راحتی نیز قابل دستیابی نیستند. تحلیل دادههای رسانههای اجتماعی وب سایتها برای موفقیت کسبوکارها حیاتی است. مقالههای داده کاوی در این حوزه تأثیرات رسانههای اجتماعی بر تصمیمات خرید اکثر مصرف کنندگان را اثبات میکنند و چنین بسترهایی را به عنوان ابزارهایی موثر در بازاریابی و استراتژیهای تجاری میدانند. بر اساس مطالعهای که اخیراً توسط Social Media Examiner انجام شده ، حدود ۹۳ درصد از مشاغل گزارش دادهاند که در معرض افزایش سوددهی قرار گرفتهاند که درصد قابل توجهی از آنها برای فروش از شبکههای اجتماعی استفاده کردهاند.

دادههای رسانههای اجتماعی دارای سه ویژگی چالش برانگیز است: بزرگ، پر حاشیه و پویا. بنابراین، با استفاده از تکنیکهای داده کاوی رسانههای اجتماعی میتوان فرآیندهای کسبوکار را بسیار سادهتر نمود. با توجه به محبوبیت بیشتر رسانههای اجتماعی در بخش تجارت و استراتژیهای بازاریابی، تکنیکهای داده کاوی میتوانند به افراد در بهبود نتایج جستجو در موتورهای جستجو کمک کنند. همچنین، این امکان فراهم میشود که کسبوکارها بینش جدیدی از دادههای خود پیدا کنند. علاوه بر این میتوانند شرایطی را برای شخصیسازی خدمات برای مشتریان فراهم کنند.

داده کاوی در بورس

بازار سهام (Stock market) به مجموعه بازارها و مبادلاتی اطلاق میشود که در آن فعالیتهای منظم خرید، فروش و انتشار سهام شرکتهای سهامی عام انجام میشود. چنین فعالیتهای مالی از طریق مبادلات رسمی نهادی یا بازارهای بدون نسخه (OTC) انجام میشود که تحت مجموعهای از مقررات تعریف شده عمل میکنند.

با توجه اینکه روند تغییرات در بخش اقتصادی، دادههای مالی با سرعت بسیار زیادی در حال تولید هستند و عدم قطعیت یکی از ویژگیهای بارز بازارهای سهام است و این امر برای سرمایه گذاران نامطلوب میباشد لذا یکی از راههای مقابله با این مشکل را میتوان تحلیل این دادههای مالی دانست.

از داده کاوی برای کشف الگوهای پنهان و پیشبینی روندها و رفتارهای آینده در بازارهای مالی استفاده میشود که مزایایی چون افزایش درآمد، کاهش هزینهها، پاسخگویی و آگاهی بیشتر در بازارهای مالی را به همراه دارد.

بازار بورس اوراق بهادار دارای یک سیستم پیچیده، ناپایدار، نامنظم، غیر خطی و پویا است. پیشبینی بازار سهام را میتوان شامل مواردی چون کشف روند بازار، شناسایی بهترین زمان خرید و فروش و تعیین استراتژی سرمایه گذاری دانست. برای درک الگوها و روندها و در نهایت پیشبینی بازار، میتوان دادههای گذشته آن را به کمک داده کاوی و تکنیکهای هوشمصنوعی، بررسی و تجزیهوتحلیل کرد.

انتخاب یک سهام و یافتن بهترین زمان خرید و فروش آن، مهم ترین مسئله برای سرمایه گذاران است. برای حل این چالش میتوان از روشهای داده کاوی مانند درخت تصمیمگیری استفاده کرد تا دادههای اقتصادی شرکتها را بررسی و روند رشد آنها در آینده را تعیین نمود و با توجه به نتایج حاصل از تحلیل دادهها، تصمیم بر خرید و فروش سهام آن شرکت نمود.

در حال حاضر محققان بسیار زیادی تمرکز خود را بر روی استفاده از داده کاوی در بازارهای مالی گذاشتهاند و از تکنیکهای زیادی همچون شبکه عصبی، خوشهبندی و قوانین مشارکتی استفاده میکنند تا بتوانند بر اساس زمانبندی، قیمت، حجم و مدلهای ریاضی، ریسکهای سرمایهگذاری را کاهش داده، سرمایهگذاران بیشتری را به سوی بازارهای مالی سوق دهند و و معاملات را به روشی سازمان یافته انجام میدهند.

داده کاوی در مدیریت

داده کاوی در حال حاضر بسیار محبوب است زیرا اکثر مشاغل ارزش اطلاعات و استفاده از آنها برای تصمیمگیری سودآورتر را درک کردهاند. امروزه در اکثر سازمانها، داده کاوی یا یک فرآیند مهم تجاری است یا به زودی خواهد بود. از آنجا که داده کاوی نسبتاً جدید است، دانش و درک برای اجرای موفق آن بسیار مهم است.

نکتهای که تقریبا تمامی کارشناسان با آن موافق هستند، اهمیت اجزاء و محتویات داده است که به نوعی هسته اصلی برای موفقیت داده کاوی محسوب میشوند و به وضوح خروجی هر پروژه داده کاوی را تحت تأثیر قرار میدهند.

داده کاوی در بخش مدیریتی فقط ایجاد راهحلهای تاکتیکی برای مسائل خاص، مانند ایجاد یک مدل نگهداری برای مشتریان جدید نیست. داده کاوی میتواند برای توسعه استراتژیهای کلی مانند استراتژی تقسیم بندی گسترده مشتریان نیز مورد استفاده قرار گیرد و در یک سطح کلی تر، از داده کاوی برای تعیین اینکه آیا استقرار یک برنامه مدیریت ارتباط با مشتری منطقی است یا نه بهره گرفت.

با توجه به اینکه امروزه مدیریت ارتباط با مشتری برای اکثر سازمانها به یک شیوه تجاری تبدیل شده است، داده کاوی اغلب به عنوان یک مولفه فناوری تحلیلی برای حل چالشهای مدیریتی در این زمینه مورد استفاده قرار می گیرد. در یک سازمان و یا شرکت هنگامی که چالش یا مشکل تجاری مشخص شد، تحلیلگران باید دادهها و اطلاعات مورد نیاز برای انجام تجزیهوتحلیلهای لازم را کشف کنند و به ایجاد یا طراحی پایگاه داده مورد نیاز بپردازند. تحلیل گران برای این کار فقط به آنچه در حال حاضر وجود دارد توجه میکنند نه آنچه را که باید در آنجا وجود داشته باشد. هنگامی که یک فایل و برخی از محتویات آن به طور بالقوه برای تجزیهوتحلیل آماده شد، به مدل سازی و تحلیل با الگوریتمهای مختلف پرداخته میشود.

اگر داده کاوی با تاکید بر مواردی چون تجزیهوتحلیل مالی، ارزیابی بازاریابی، روند رشد کارکنان و یا ارزیابی محصولات و خدمات از دیدگاه مشتریان مورد استفاده قرار گیرد، به شرکتها و سازمانها این امکان را می دهد تا عوامل کلیدی تجارت خود را از منظر مواردی مانند محصول، موقعیت، رقابت، رضایت مشتری، فروش و هزینههای تجاری مشخص کنند. در نتیجه مدیران میتوانند تصمیمگیری بهتری برای آینده شرکت و یا سازمان خود داشته باشند و حیات خود در بازار را حفظ کنند.

مثال داده کاوی

امروزه بسیاری از فعالیتهای روزمره افراد توسط نرمافزارها و وب سایتها انجام میگیرد. هوشمصنوعی و داده کاوی در بسیاری از این نرمافزارها سبب ایجاد فضایی بهتر شدهاند. در ادامه، برای درک بهتر کاربرد داده کاوی در دنیای واقعی مثالهایی آورده شده است.

داده کاوی در اینستاگرام

بنا بر مطلب منتشر شده در فوربس اینستاگرام، یک برنامه شبکه اجتماعی برای به اشتراک گذاری عکسها و فیلمهای کاربران است که در سال ۲۰۱۰ راه اندازی شد و امروزه، ۸۰۰ میلیون کاربر فعال ماهانه دارد و متعلق به شرکت فیس بوک است. روزانه ۷۰ میلیون عکس در اینستاگرام بارگذاری میشود و افراد با نشان دادن محبت خود، اظهار نظر و استفاده از هشتگها با هر یک از این پستها ارتباط برقرار میکنند. تمامی این تراکنشها منجر به ایجاد حجم عظیمی از دادهها است. پس از تجزیهوتحلیل و همچنین به طور فزاینده ای از طریق الگوریتمهای داده کاوی، میتواند اطلاعات تجاری و بینش باورنکردنی در مورد رفتار انسان ارائه دهد و باعث میشود مدیرعامل اینستاگرام کوین سیستروم بگوید: “ما همچنین یک شرکت بزرگ داده خواهیم بود.” برای مثال از جمله کاربردهای داده کاوی و الگوریتمهای یادگیری ماشین در این نرمافزار را میتوان موارد زیر دانست.

- کاوش صفحه و بهبود عملکرد جستجو

- تبلیغات هدفمند

- مطالعه بر روی رفتارهای انسانی

داده کاوی در لینکدین

لینکدین یک شبکه اجتماعی برای بهبود کسبوکارها است. از لینکدین برای آشنایی کاربران با یکدیگر و همچنین شناخت حوزه کاری افراد استفاده میشود. امروزه افراد از این سیستم برای پیدا کردن فرصتهای شغلی استفاده میکنند. در هر صفحه شخصی از افراد یا کسبوکارها اطلاعات بسیار زیادی را میتوان یافت که از جمله آنها سن، جنسیت، سوابق کاری، سوابق تحصیلی، مهارتها و علایق افراد است. این امر معادل با حجم انبوهی از اطلاعات است که میتوان از طریق داده کاوی به دانش بسیار عمیقی در خصوص بازار، علایق کاری و کسبوکارها دست پیدا کرد. با یک جستجوی ساده در اینترنت میتوان این نکته را درک کرد که داده کاوی اطلاعات موجود در لینکدین چه میزان اهمیت دارد. هم اکنون سازمانها و شرکتهای زیادی در پی کشف این اطلاعات هستند تا بتوانند بر مبنای آنها برای آینده کاری خود برنامهریزی کنند.

داده کاوی در وبسایت آمازون

آمازون بزرگترین فروشگاه اینترنتی با شعار “همه چیز زیر یک سقف” است که در هر دقیقه دادههای بسیار زیادی تولید میکند. این شرکت بزرگ با بررسیهای بسیار به این نتیجه رسیده است که با افزایش تنوع در گزینههای موجود برای خرید، خریداران دچار سردرگمی شده و در نتیجه قدرت تصمیمگیری خود را از دست میدهند.

برای مقابله با این امر، آمازون از دادههای بزرگ جمعآوری شده از مشتریان در حین مرور، برای ایجاد و تنظیم دقیق موتور توصیه ای خود استفاده میکند. هرچه آمازون اطلاعات بیشتری در مورد خریداران داشته باشد، بهتر میتواند پیشبینی کند که افراد تصمیم به خرید چه چیزی را دارند.

آمازون برای افزایش دانش خود از مشتریانش هنگام استفاده آنها از سایت، اطلاعات مربوط به هر یک را جمعآوری میکند. علاوه بر آن دادههای مربوط به تاریخچه خرید، مطالب مورد بازدید، آدرس مقصد (جهت آگاهی از میزان درآمد خریداران بر اساس محل زندگیشان) و بررسی نظرات و بازخوردشان در سایت به این شرکت در بهبود مدیریت ارتباط با مشتری کمک میکند.

برخی از کتابهای داده کاوی

در ادامه به معرفی برخی از کتابهای پرکاربرد در زمینه داده کاوی پرداخته شده است.

کتاب Data Mining (The Textbook)

نویسندگان: Aggarwal ,Charu C.

سال انتشار:۲۰۱۵

این کتاب درسی جنبههای مختلف داده کاوی را از مبانی تا انواع پیچیده دادهها و کاربردهای آنها را بررسی میکند و تنوع وسیعی از حوزههای مشکل را برای مسائل داده کاوی به تصویر میکشد. فراتر از تمرکز سنتی بر روی مشکلات داده کاوی، معرفی انواع دادههای پیشرفته مانند متن، سری زمانی، توالیهای مجزا، دادههای فضایی، دادههای نمودار و شبکههای اجتماعی است. تا کنون، هیچ کتابی به همه این موضوعات به صورت جامع و یکپارچه نپرداخته است.

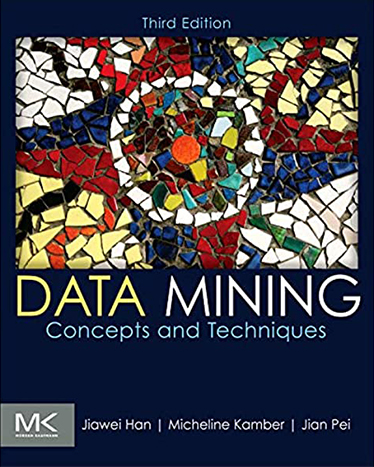

کتاب Data Mining: Concepts and Techniques

نویسندگان: Jiawei Han, Micheline Kamber, Jian Pei

سال انتشار:۲۰۱۱

این کتاب مفاهیم و تکنیکهایی را در پردازش دادهها یا اطلاعات جمعآوری شده ارائه میدهد که در برنامه های مختلف مورد استفاده قرار میگیرد. به طور خاص، داده کاوی و ابزارهای مورد استفاده در کشف دانش از دادههای جمعآوری شده را توضیح میدهد. این کتاب به عنوان کشف دانش از دادهها (KDD) نامیده می شود. این کتاب بر امکان پذیری، سودمندی، اثربخشی و مقیاس پذیری تکنیکهای مجموعه دادههای بزرگ متمرکز است. پس از توصیف داده کاوی ، این نسخه روشهای دانستن، پیش پردازش، پردازش و ذخیره سازی دادهها را توضیح می دهد. سپس اطلاعات مربوط به انبارهای داده، پردازش تحلیلی آنلاین (OLAP) و فناوری مکعب داده را ارائه می دهد.

کتاب: Data Mining (Practical Machine Learning Tools and Techniques)

نویسندگان: Ian H. Witten, Eibe Frank, Mark A. Hall, Christopher Pal

سال انتشار:۲۰۱۶

این کتاب با نام داده کاوی” ابزارها و تکنیک های عملی یادگیری ماشین” به چاپ چهارم رسیده است و در آن توصیههای کاربردی در مورد کاربرد ابزارها و تکنیکها در شرایط واقعی داده کاوی آورده شدهاست و زمینه مفیدی را در مفاهیم یادگیری ماشین ارائه میدهد. چهارمین ویرایش این کتاب بسیار تحسین برانگیز است چراکه در زمینه داده کاوی و یادگیری ماشین، به خوانندگان هر آنچه را که باید برای پیشرفت نیاز داشته باشند، از آماده سازی ورودی ها، تفسیر خروجیها، ارزیابی نتایج، تا روشهای الگوریتمی در قالب روشهای موفقیتآمیز داده کاوی میآموزد.

کتاب Mining of Massive Datasets

نویسندگان: Jure Leskovec, Anand Rajaraman, Jeffrey David Ullman

سال انتشار: ۲۰۱۹

این کتاب که توسط افراد برجسته در پایگاه داده و فناوریهای وب نوشته شده است. سایتها و شبکههای اجتماعی مجموعه دادههای بسیار بزرگی را ارائه میدهند که با استفاده از داده کاوی میتوان از آنها اطلاعات سودمندی را جمعآوری کرد. این کتاب بر الگوریتمهای عملیای تمرکز دارد که برای حل مشکلات کلیدی در داده کاوی استفاده شدهاند و میتوانند با دقت بالایی حتی در بزرگترین مجموعه دادهها نیز به کار گرفته شوند. نویسندگان ترفندهای الگوریتمهای هش و پردازش جریان حساس به مکان را برای استخراج دادهها که برای پردازش جامع بسیار با اهمیت هستند را توضیح می دهند. ویرایش سوم کتاب شامل پوشش جدید و گستردهای در مورد درختان تصمیم گیری، یادگیری عمیق و استخراج نمودارهای شبکه های اجتماعی است.

کتاب Data Mining and Machine Learning

نویسندگان: Mohammed J. Zaki, Wagner Meira, Jr

سال انتشار: ۲۰۲۰

الگوریتمهای اساسی در داده کاوی و یادگیری ماشین، اساس علم داده را تشکیل میدهند و از روشهای خودکار برای تجزیه و تحلیل الگوها و مدلها برای انواع دادهها در برنامههای کاربردی اعم از اکتشافات علمی تا تجزیه و تحلیل تجاری استفاده میکنند. این کتاب درسی برای دوره های کارشناسی ارشد و فارغ التحصیلان کارشناسی یک مرور جامع و عمیق از داده کاوی، یادگیری ماشین و آمار ارائه میدهد و راهنمایی جامعی برای دانشجویان، محققان و متخصصین ارائه میدهد. این کتاب پایه و اساس تجزیه و تحلیل دادهها، استخراج الگوها، خوشهبندی، طبقهبندی و رگرسیون را با تمرکز بر الگوریتمها و مفاهیم جبری، هندسی و احتمالی تشکیل میدهد. نسخه دوم این کتاب به روشهای رگرسیون، از جمله شبکههای عصبی و یادگیری عمیق اختصاص داده شده است.

جمع بندی

داده کاوی دنیای بسیار بزرگی است که در هر لحظه دانش جدیدی به آن اضافه میگردد. این روزها داده کاوی در بخشهای زیادی از زندگی روزمره بشر نفوذ پیدا کرده و موجب راحتتر و سادهتر شدن مسیر زندگی میشود. در سالهای اخیر بیشتر نام داده کاوی در کنار واژههایی چون یادگیری ماشین، هوشمصنوعی و کلان دادهها میآید. هر چهار علم گفتهشده در کنارهم به توسعه و پیشرفت کسبوکارها میانجامند و دارای ارتباط مستقیمی با یکدیگر هستند. در واقع میتوان حجم زیادی از دادهها را توسط داده کاوی تحلیل و بررسی کرد و سپس با استفاده از الگوریتمهای یادگیری ماشین آن را مدل و در نهایت با استفاده از هوشمصنوعی آن را هوشمند ساخت.

برگرفته از: هوشیو

برای مشاهده لیست همه ی پرسشنامه های استاندارد لطفا همین جا روی پرسشنامه استاندارد کلیک فرمایید.

تحلیل داده های آماری برای پایان نامه و مقاله نویسی ،تحلیل داده های آماری شما با نرم افزارهای کمی و کیفی ،مناسب ترین قیمت و کیفیت عالی انجام می گیرد.

نرم افزار های کمی: SPSS- PLS – Amos

تعیین حجم نمونه با:Spss samplepower

روش های تماس:

Mobile : 09143444846 واتساپ – تلگرام

Telegram: @abazizi4